Kimi.AI 是一款由 月之暗面公司 开发的国产人工智能助手,基于多用途大语言模型,为用户提供多种服务,帮助提升工作和学习效率。Kimi.AI 可用于文本处理、对话问答、知识管理等多种场景,是一个功能强大的 AI 工具。

Github 项目地址:KIMI AI Free 服务

在 UGOS Pro 系统上,推荐使用项目 Docker Compose 快速部署容器,适合需同时管理多个容器的场景,这种方法简化了容器的部署与管理工作。以下是使用 Docker Compose 部署 Kimi.AI 的详细步骤。

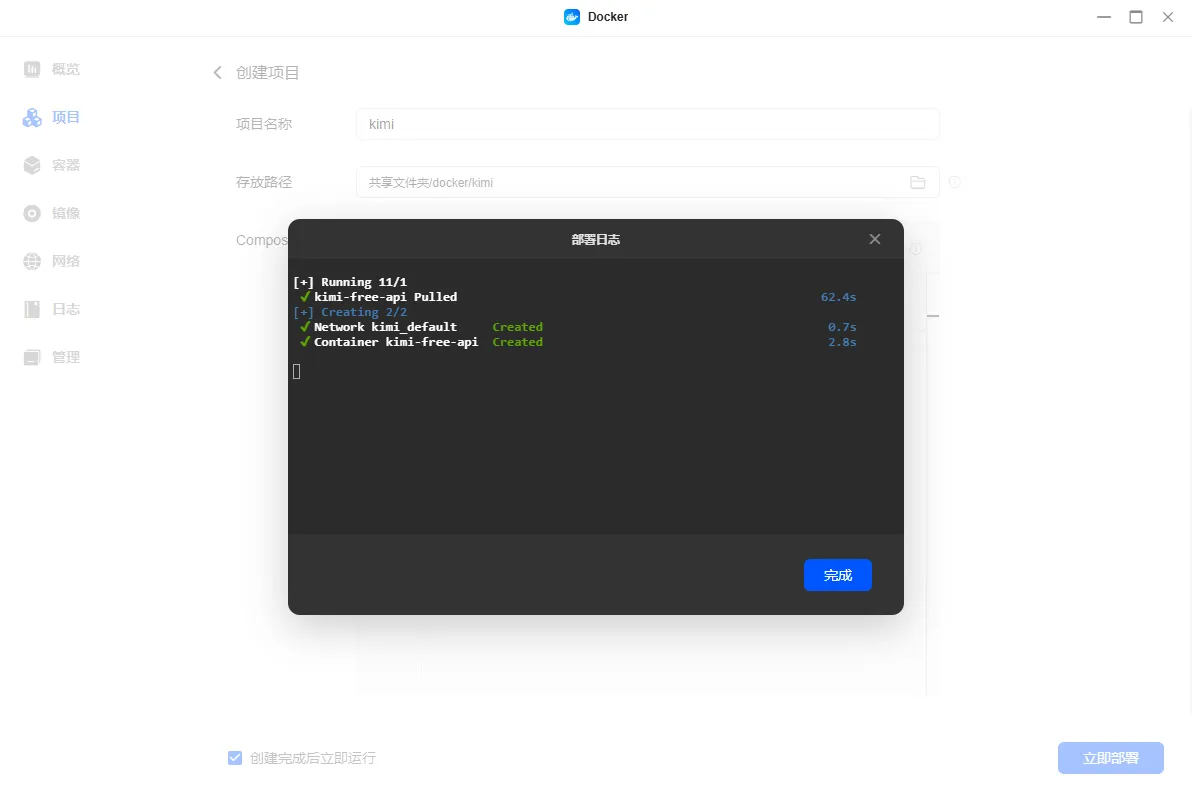

在 UGOS Pro 系统中,打开 Docker 应用,点击【项目】 > 【创建】,启动项目创建向导。

在项目创建向导中,上传以下 Kimi.AI 的 Docker Compose 配置文件:

services:

kimi-free-api:

container_name: kimi-free-api

image: vinlic/kimi-free-api:latest # 镜像名

restart: always # 容器重启策略

ports:

- "8011:8000" # Web 界面端口

environment:

- TZ=Asia/Shanghai # 容器时区

以下是关键参数的解释:

image: 指定 Docker 镜像, latest表示使用最新版本的镜像。

restart:定义容器重启策略,always表示当容器停止时自动重启。

ports: 定义容器内部端口和 NAS 端口的映射。

8011:8000 表示 NAS 的 8011 端口映射到容器的 8000 端口,用于访问 Web 应用界面。

environment:

TZ=Asia/Shanghai :设置容器时区为中国上海(Asia/Shanghai),您可以根据所在的时区进行调整,例如美国时区(America/New_York)或欧洲时区(Europe/London)。

注意:

部署前请参阅 vinlic/kimi-free-api 镜像的官方文档,如果该镜像有特定的部署指南或要求,请参照其官方说明或README文件。

配置文件中的 ./ 表示当前目录路径;NAS 本地路径与容器内部路径的映射需按需调整。

上传配置文件后,点击【立即部署】,系统会自动拉取镜像并启动容器。

部署完成后,通过浏览器访问以下地址进入 Kimi.AI 界面:

http://<NAS_IP>:8011

请将 <NAS_IP> 替换为 NAS 的实际 IP 地址,例如:http://192.168.22.153:8011。

镜像下载失败处理方法:

Docker 镜像加速器:建议配置加速器以提高下载速度,特别是在中国内地的网络环境下。参考《Docker配置镜像加速和镜像源》了解如何设置。

代理设置:在某些情况下,您可能需要配置 HTTP/HTTPS 代理来辅助下载,详见《Docker通过设置代理下载镜像》。

要访问 MKVtoolnix 的 Web 界面,请打开浏览器,访问部署地址,进入登录页面。

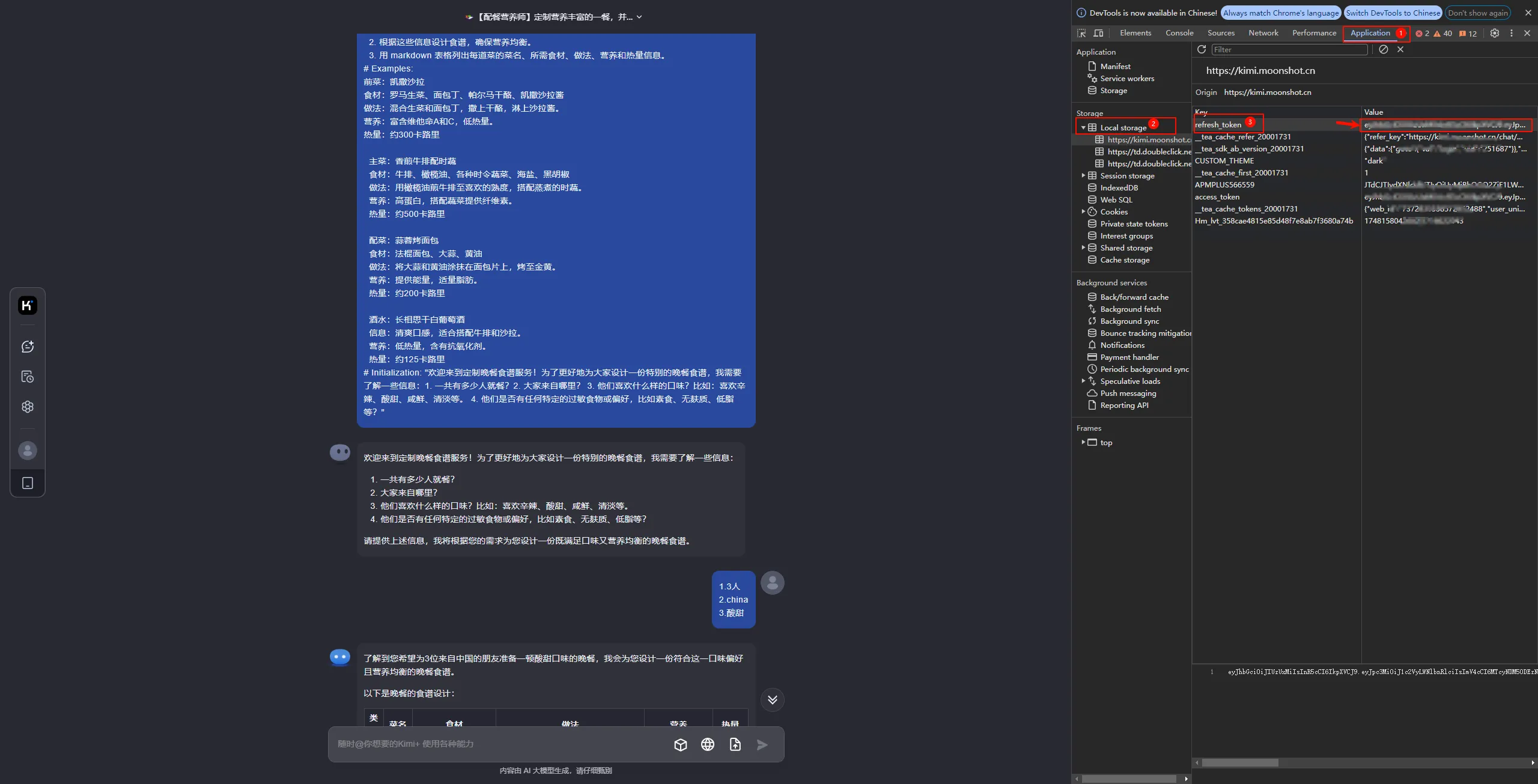

前往 Kimi 官网注册并登录。

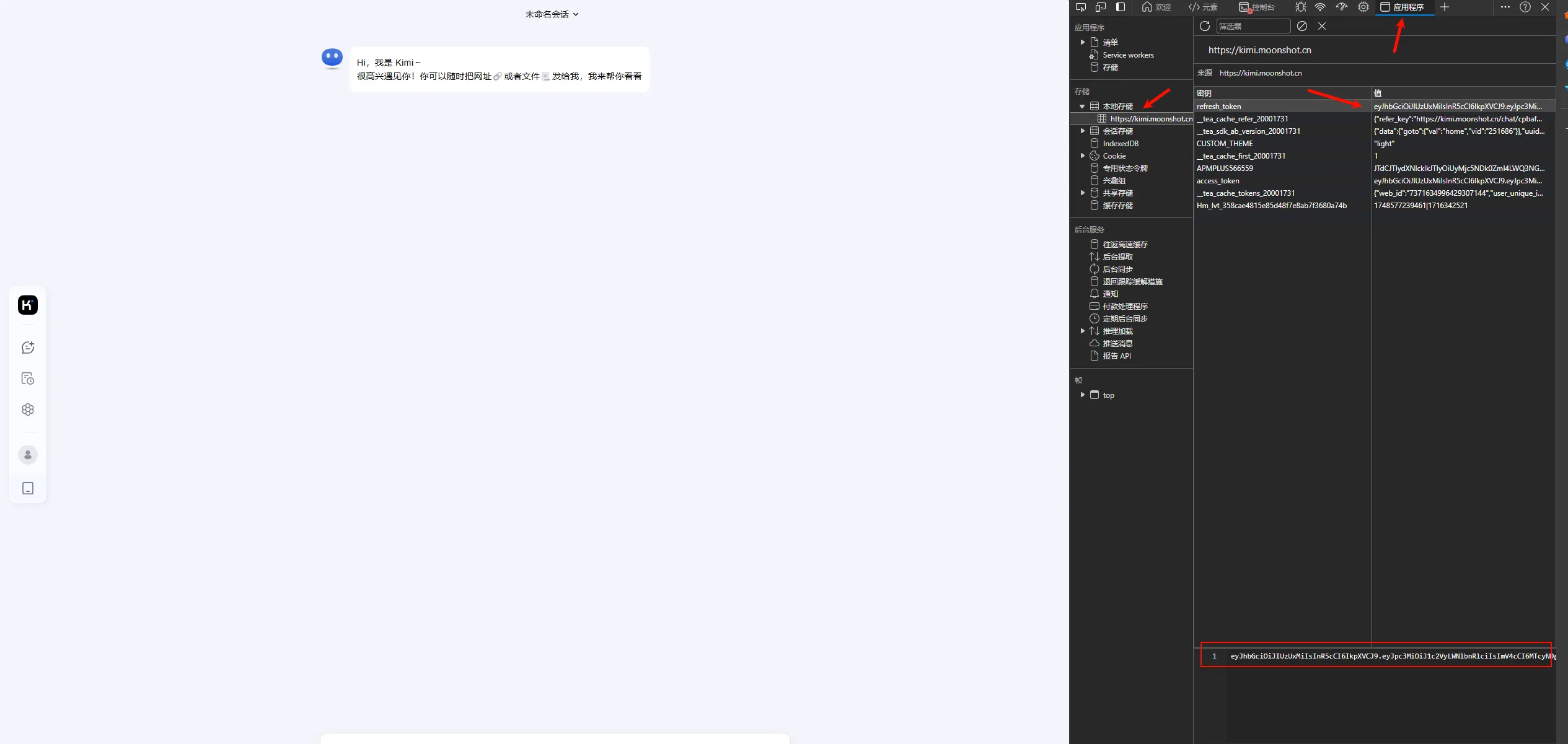

发起一条对话,按下 F12 打开浏览器开发者工具。

Chrome 浏览器:选择“Application” > “Local Storage”,找到 refresh_token 并复制保存。

Edge 浏览器:选择“应用程序” > “本地存储”,找到 refresh_token 并复制保存。

免费用户限制每 3 小时内仅可进行 30 轮长文本问答(短文本不限)。

您可以通过提供多个 refresh_token 实现多账号轮询,格式如下:

Authorization: Bearer TOKEN1,TOKEN2,TOKEN3

服务会从中自动挑选一个账号进行请求。

在运行 kimi-free-api 后,可通过 LobeChat、NextChat、Dify 等客户端接入 API。以下为使用 ChatGPT-Next-Web 的安装指南:

前往 Docker 镜像仓库,搜索 yidadaa/chatgpt-next-web 并下载最新版本镜像。

下载完成后,在 Docker 中创建容器:

容器名称:自定义名称(如 chatgpt-next-web)。

环境变量配置:

OPENAI_API_KEY=<refresh_token>

BASE_URL=http://<NAS_IP>:8011

CUSTOM_MODELS=-all,+kimi

端口映射:选择合适的端口映射,例如 3011:3000。

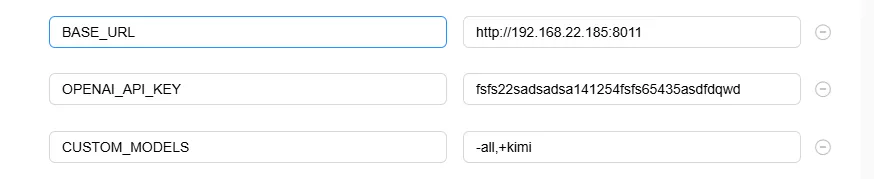

如果您已安装 ChatGPT-Next-Web,只需修改以下环境变量:

OPENAI_API_KEY:填写获取的 refresh_token 值。

BASE_URL:填写 kimi-free-api 服务的地址和端口号。

CUSTOM_MODELS:更新为 -all,+kimi。

配置完成后,启动容器。通过浏览器访问:http://<NAS_IP>:3011

进入设置后可以看到模型已经被设置为 kimi。

点击左侧“新的聊天”即可开启聊天对话

请注意,本教程中的镜像由第三方开发和维护,教程仅供参考。绿联不承担因用户操作不当、第三方软件漏洞或镜像更新引发的风险,包括但不限于:

· 第三方镜像可能导致您在 UGOS Pro 系统中的文件意外修改或删除。

· 使用不安全的镜像可能导致数据上传至第三方服务器,存在隐私和数据泄露风险。

· 为确保系统稳定和数据安全,请谨慎选择可信来源的第三方镜像。

其他注意事项:

1. 容器的文件/文件夹路径仅供参考,您可以根据个人习惯创建。

2. 网页访问的容器端口和本地端口应保持一致。如有冲突,请改为未使用的端口。容器之间的本地端口不能相同,端口冲突会导致无法启动容器。

3. 容器的网页链接仅在 bridge 桥接模式下可访问。

4. 镜像仅提供搭建教程,具体使用方法和深度玩法请网上搜索参考。

5. 镜像由第三方开发,具体配置变动和 bug 修复请关注相关官方信息。

6. 建议将 Docker 配置目录存储在 SSD 硬盘中,以避免机械硬盘影响系统性能。